Higress 新增 MCP 服务管理,助力构建私有 MCP 市场

前言

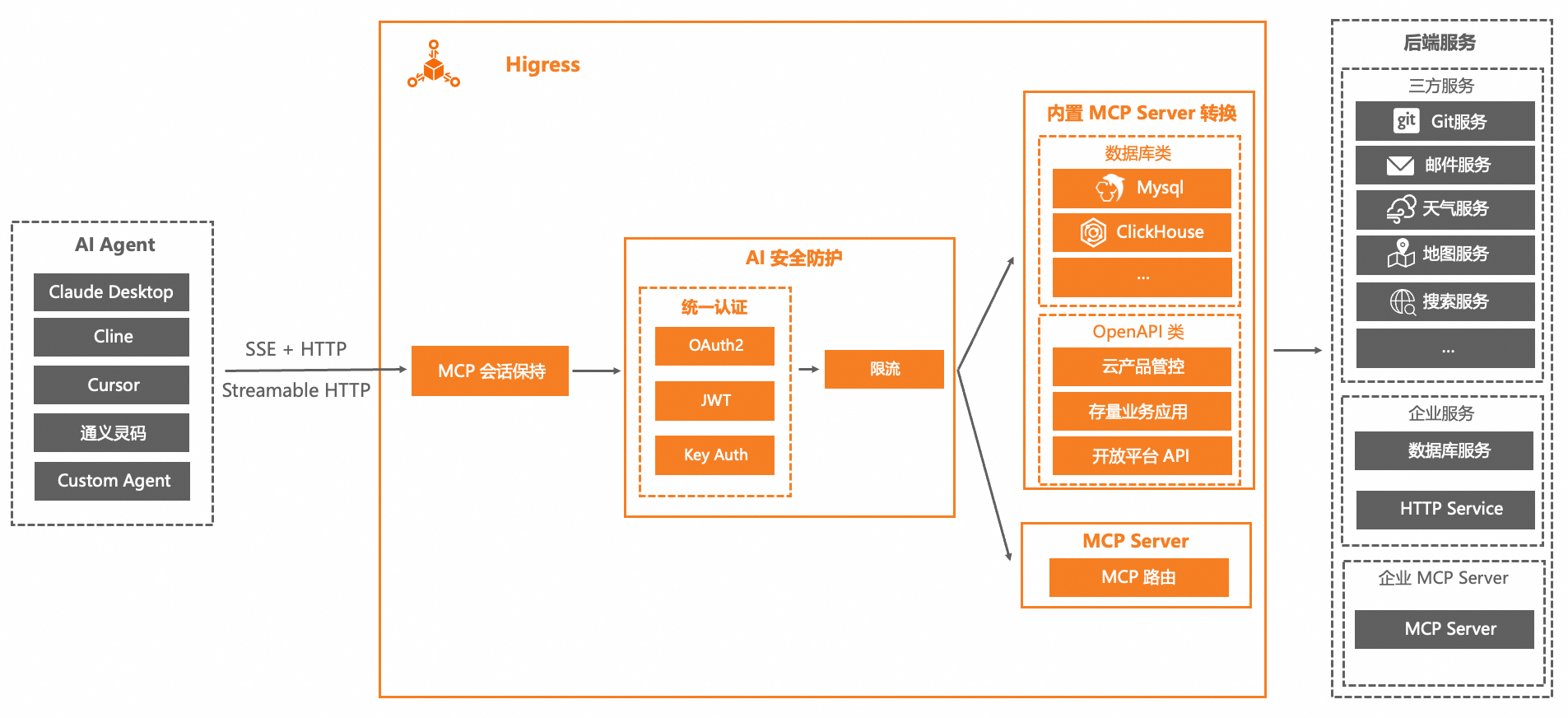

今年 3 月份 MCP 协议成为了 AI 的新一轮热点,被大多数人所熟知,彼时 Higress 快速进行跟进,新增了 MCP 协议转换功能,详见:https://higress.cn/ai/mcp-quick-start ,该方案解决了以下问题:

- 引入 Redis,借助其 pub/sub 特性,解决了 SSE 协议会话保持的问题

- 提供了 OpenAPI 转换成 MCPServer 的能力,仅需提供符合 OAS 3.0 规范的 OpenAPI 文档,即可自动转换成网关托管的 MCPServer

- 提供了 Go Template 和 GJSON 表达式,来对请求和响应模版进行精细化处理,这使得用户只需要变更配置即可完成对 MCPServer 的调优,且变更过程流量完全无损,SSE 连接也不会断开。

该功能一经推出,迅速在开源社区引起了用户广泛的关注,同时在交流群中,也有大量用户反馈了配置失败的问题,因为该功能过于原子化且配置复杂,用户很容易遇到配置失败的问题,为进一步增加用户体验,我们决定将 Higress MCP 相关的能力以场景化的方式,集成在 Higress Console 中,即 MCP 服务管理模块。

用户可以在 Higress 2.1.5 版本中正式体验该文中提及的所有特性。

Higress MCP 服务管理介绍

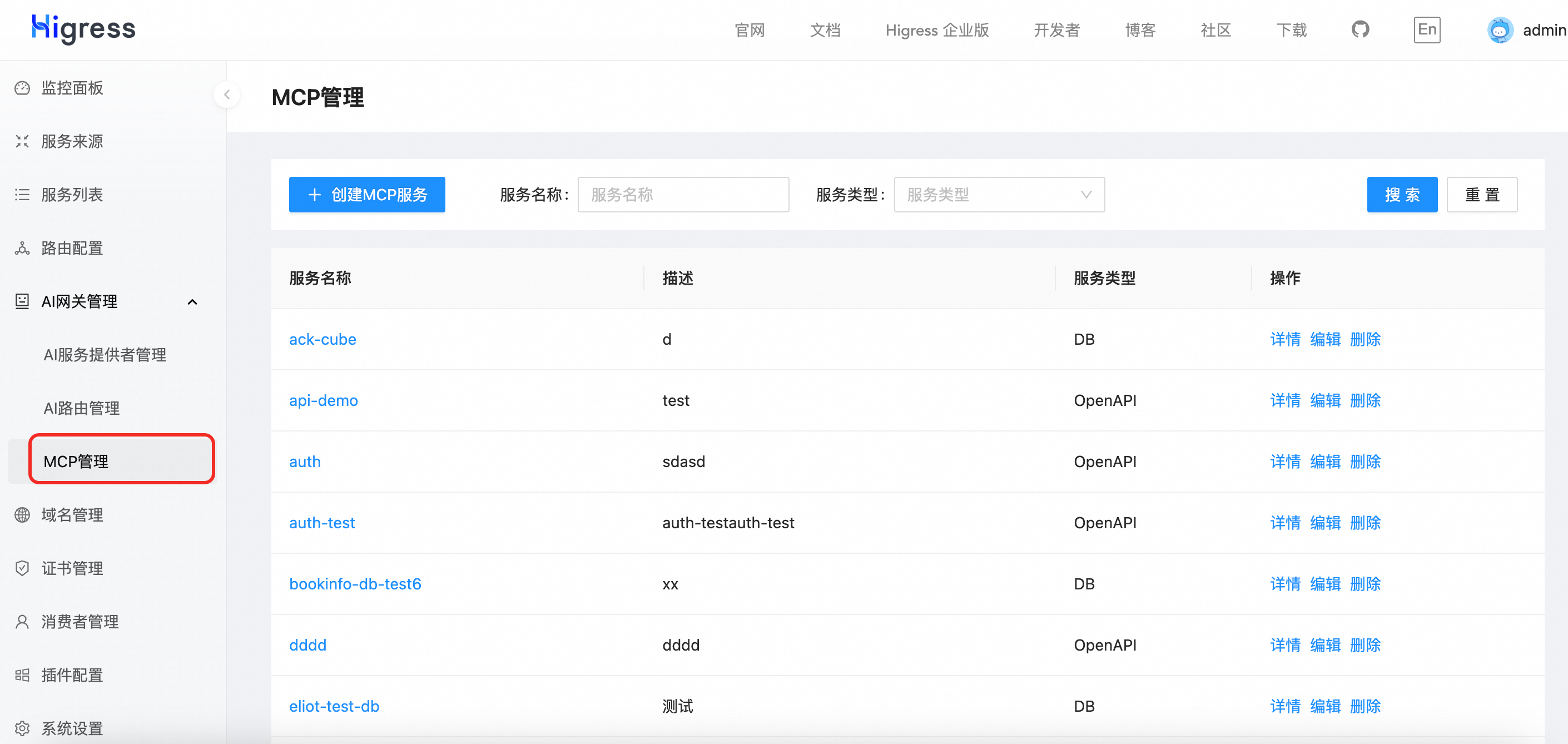

Higress MCP 服务管理功能概览

Higress MCP 服务管理模块提供了以下能力:

- OpenAPI 转换 MCP。根据用户提供的 OAS 3.0 文档,连接网关已有的 HTTP 后端服务,即可自动转换成 MCPServer。

- DB 转换 MCP。用户仅需将数据库实例配置为网关的后端服务,即可自动转换成 MCPServer,目前支持 MySQL、PostgreSQL、Clickhouse、Sqlite。

- MCP 直接路由。可以直接代理 SSE/Streamable 协议的后端服务。

- MCP 认证授权能力。

站在一个 Higress 开源贡献者的视角,我还是先澄清下 Higress 本身的定位,其主要还是承担 AI 网关/MCP 网关的职责,作为一个基础设施,帮助企业更好地构建自身的 MCP 市场,其提供的 MCP 特性支持,可以非常友好地跟 MCP 应用商店(如 mcp.so)、MCP 客户端市场(Cline、Cursor、Cherry Studio)、平台型市场(百炼、魔搭、Dify)等场景结合,Higress 跟这些场景并不是竞争关系。